연구 소개

- 연구

- 연구 소개

공중로봇 자율 비행을 위한 딥 강화 학습 기술 개발

- AI융합대학

- 2018-01-01

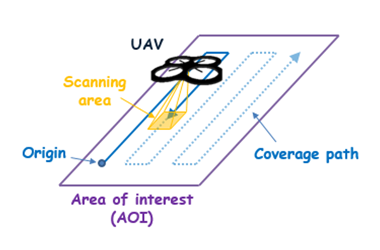

최영식 교수의 RML 연구실에서 단안 카메라를 통해 획득한 영상에서 Semantic segmentation 및 Depth 등의 시각 정보를 추출하여, 이를 기반으로 공중로봇이 장애물을 피해 목표지점까지 자율 비행하도록 하는 딥 강화학습(Deep Reinforcement Learning) 기술을 개발했다.

본 연구는 삼성전자의 미래기술육성센터의 지원으로 2016년 9월부터 2018년 8월까지 진행되었다. 본 연구에서 개발한 시각 정보 추출 인공 신경망(Artificial Neural Network)을 실제 한국항공대 주변 풍경에 적용해본 영상이다. 아래 [영상 1]은 3가지 화면으로 구성되어 있으며, 위에서부터 RGB 이미지, Semantic Segmentation, 그리고 Depth를 나타낸다. CityScape 및 KITTI 데이터셋으로 실험한 결과 기존의 인공 신경망과 비교했을 때, 신경망의 크기는 1/20에서 1/30이지만 정확성은 최대 10% 더 높은 결과를 보였다. 신경망의 크기를 크게 줄인 결과 임베디드 GPGPU 장비인 nVidia의 Jetson TX2에서도 작동할 수 있었으며, 10Hz의 속도로 시각 정보를 추출하는데 성공했다.

[영상 1] 실제 환경에서의 시각 정보 추출 시험

[영상 2] 딥 강화학습(Deep Reinforcement Learning)을 이용한 공중로봇의 장애물 회피 훈련

위 [영상 2]는 본 연구를 통해 추출한 시각 정보를 이용해 시뮬레이션 환경에서 자율비행을 학습시킨 결과이다. Microsoft의 AirSim 환경에서 최대 16대의 에이전트가 동시에 딥 강화학습을 진행했다. GPS를 통해 목표 지점을 정해주면 공중 로봇이 장애물을 피해 목표 지점까지 비행하도록 학습시켰다. 약 24시간 학습한 후 충돌 없이 목표 지점까지 비행할 확률이 50%에 달했으며 약 48시간 학습 후에는 90% 이상에 달했다.

[영상 3] 실제 환경에서의 공중로봇 장애물 회피 시험

위 [영상 3]은 48시간의 시뮬레이션 학습을 마친 후 이를 실제 환경에 적용하여 실험한 결과이다. 공중로봇으로는 Parrot의 Bebop 2.0을 활용했으며, GPGPU 장비로는 nVidia의 Jetson TX2를 활용했다. 공중로봇의 단안 카메라가 이미지를 촬영하여 GPGPU 장비로 이를 전송하면, GPGPU 장비가 5Hz로 공중로봇의 비행 방향(Heading)과 속력을 제어한다. 실험 결과 목표 지점까지의 경로상에 장애물이 존재하면 약 5m에서 10m 전에 미리 비행 방향을 변경했으며, 장애물과 가까워질 수록 속력을 줄이는 것을 확인했다. 또한 장애물이 이동하더라도 충돌하지 않고 지속적으로 비행 방향과 속력을 조절하는 것을 확인했다. 다만 시뮬레이션 환경 상 움직이는 장애물에 대한 훈련을 실시하지 않았기 때문에, 충돌은 피하더라도 목표 지점까지 비행하는 경로를 찾는데는 실패하는 경향을 보였다.